在官网介绍他这个研究的时候,马斯克惯例是不提此前的类似研究,所以许多人得到的印象是,他正单枪匹马开创一种崭新的技术,肩负解放人类的重担。

实际上,医学界做这种研究已经超过十年,而且已经有不错的成果。我之前介绍过其中一个案例(How Artificial Intelligence Gave a Paralyzed Woman Her Voice Back | UC San Francisco (ucsf.edu))。

做那个研究的团队是加州大学旧金山分校的。今年,另一个团队开发了另一个脑机接口设备。这个团队也属于加州大学,只不过是戴维斯分校的。

他们的试验对象是45岁的 Casey Harrell. 他患有侧索硬化症。这个病破坏运动神经功能,让人逐渐无法控制自主运动,不仅包括四肢运动,也包括口腔肌肉,这会让他们没法清晰地说话。

但受影响的只是运动神经,也就是外周神经的一部分。大脑本身并没有问题,病人脑子很清醒,思维正常,能组织语言,只是想要用嘴巴说出心里的话时,肌肉却不听使唤。

Harrell 接受治疗之前,即便是常年照料他的护工,听他说话时,每分钟也只能大约听出6个有意义的单词。

这种感觉就类似灵魂被锁在了牢房里。

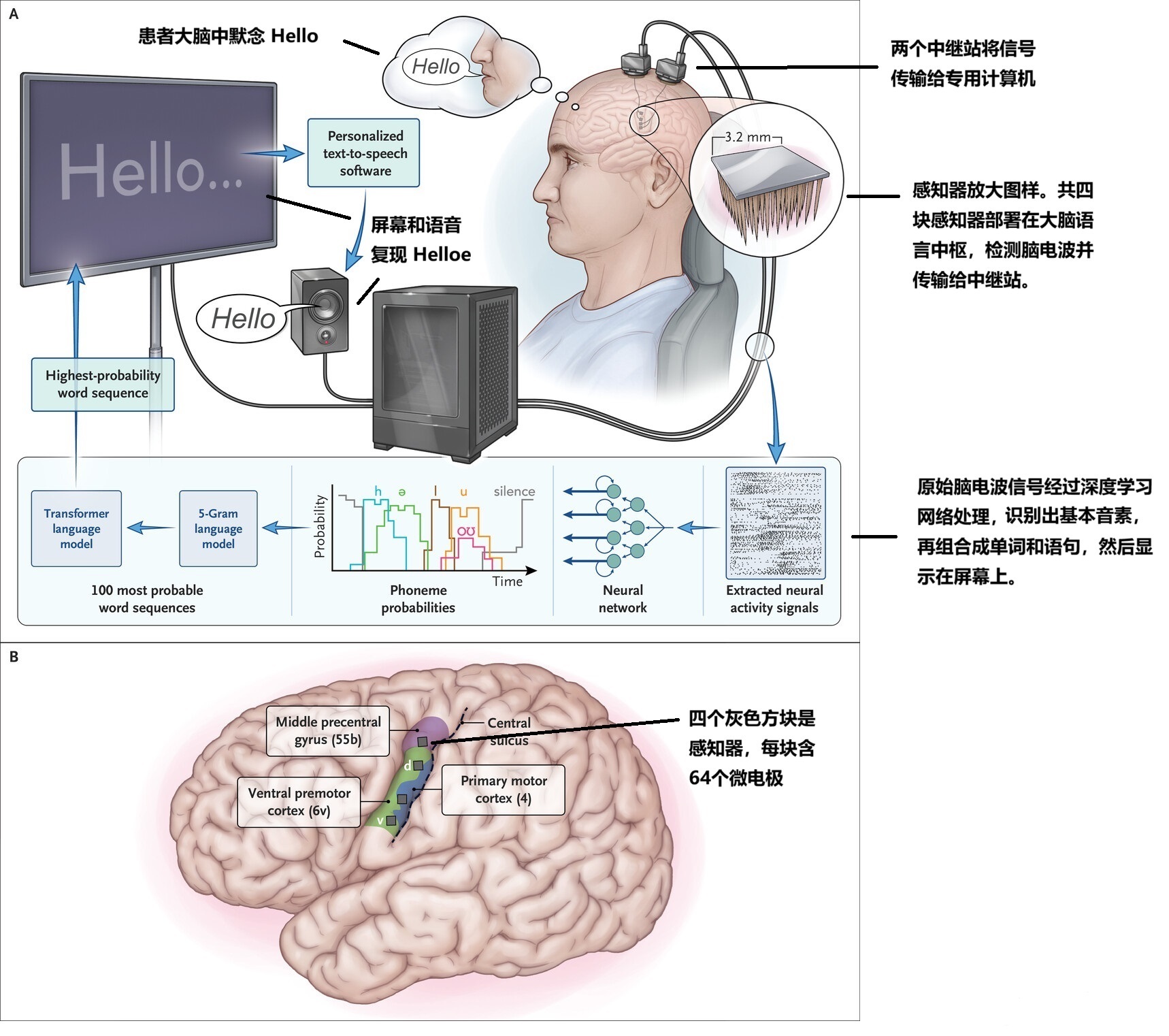

David Brandman 是戴维斯分校的神经外科医生。他给 Harrell 做手术,在颅顶打开一个小窗,植入四片传感器,这些传感器上有256个电极,可以从 Harrell 大脑的语言中枢采集信号,输送给固定在颅骨上的一个中继站。

从中继站如何传输给计算机,可以无线,也可以有线。Harrell 因为肢体瘫痪,活动基本局限在轮椅里,“行动便利”并不是特别重要的考虑,所以采用的是有线传输,通过一个工业标准接口(HKMI),可以连接到计算机。

伤口愈合,病人身体状况稳定之后,开始做数据训练。Harrell 在脑子里默念某个字,电极拾取此时产生的脑电波,对比字和脑电波形的关系,找到规律之后,计算机可以从脑电波识别出各个基本音素,比如 a 或是 e,s 或是 t 等等。Brandman 团队开发的识别软件相当不错,只用50个单词做样本,经过30分钟训练,识别准确率就达到99.6%。

这部分得益于最近出现的人工智能突破。他们在训练过程中,采用了深度学习神经网络,以及谷歌的转换器,就是支撑人工智能聊天工具 chagGPT 的那些核心技术。

当然,因为生物功能的多样性,小样本并不一定代表全局。后续训练把单词量增加到超过十二万,最后的识别准确率是97.5%。这是真正能代表全局的数字,而且是个非常漂亮的数字。人类在听别人说话时,也并不总是能听清楚的。若是真去统计识别准确率,人类的这个数据未必就高于97.5%。

团队并没有私藏这样出色的软件,而是对大众开源,其他研究人员可以免费获得。

识别音素的能力养成了,就可以根据音素组合成单词。这一步 Brandman 团队不需要自己做。已经有人制作出这种组词软件,也是免费对公众提供的。

识别能力建立之后,进入实际使用。专用的计算机解析信号,转换成文字,在屏幕显示,并且可以朗读出来。朗读用的是 Harrell 本人的声音。之前他有视频记录。计算机只要“听”几段他的讲话录音,就可以很逼真的模拟出他的“原声”。

这台计算机还有蓝牙通讯渠道,可以把信号传输到 Harrell 的个人电脑里,于是可以做其他文本工作,比如写邮件。

第一次通过计算机跟别人实时对话时,Harrell 激动得哭了。可以理解。这等于是把他囚禁多年的灵魂给释放出来了。

戴维斯分校这个技术不是首创,甚至旧金山分校那个也不是“史上第一”。介绍这一款,是因为看到这个技术可以稳定重复。而“可重复性”是检验靠谱程度的黄金标准之一。

顺便说一下,这次手术的颅骨切口是5x5厘米,大约鸡蛋大小。而最近有个新技术,能让这样的切口大幅度缩减。这个技术是牛津大学和剑桥大学联合开发的。团队领导是牛津大学副教授 Christopher Proctor。他说他看到日本折纸艺术,忽然来了灵感,就琢磨怎么把大脑植入传感器做成可折叠的。他们真的成功研发出这样一种可折叠电极列阵,实验效果达到要求。用这样的技术,只需要在颅骨上钻一个青豆大小的孔,就可以把折叠成束的电极植入大脑内部,然后在里面展开。这大大减少了感染风险,也明显缩短康复时间。

参考资料:

https://medicalxpress.com/news/2024-08-brain-interface-als.html?utm_source

https://www.nejm.org/doi/full/10.1056/NEJMoa2314132?logout=true